Los motores de búsqueda como Google utilizan robots (también conocidos como bots o arañas) para rastrear e indexar el contenido de los sitios web. Sin embargo, no todos los elementos de un sitio web son relevantes o necesarios para estos motores de búsqueda. Ahí es donde entra en juego el archivo robots.txt. Este pequeño pero poderoso archivo ayuda a guiar a los robots de los motores de búsqueda sobre qué partes de tu sitio deben ser exploradas y cuáles deben ser omitidas. En este post, vamos a profundizar en el archivo robots.txt y, más específicamente, en la directiva Disallow, que es una forma efectiva de restringir el acceso a ciertas áreas de tu sitio web.

¿Qué es robots.txt?

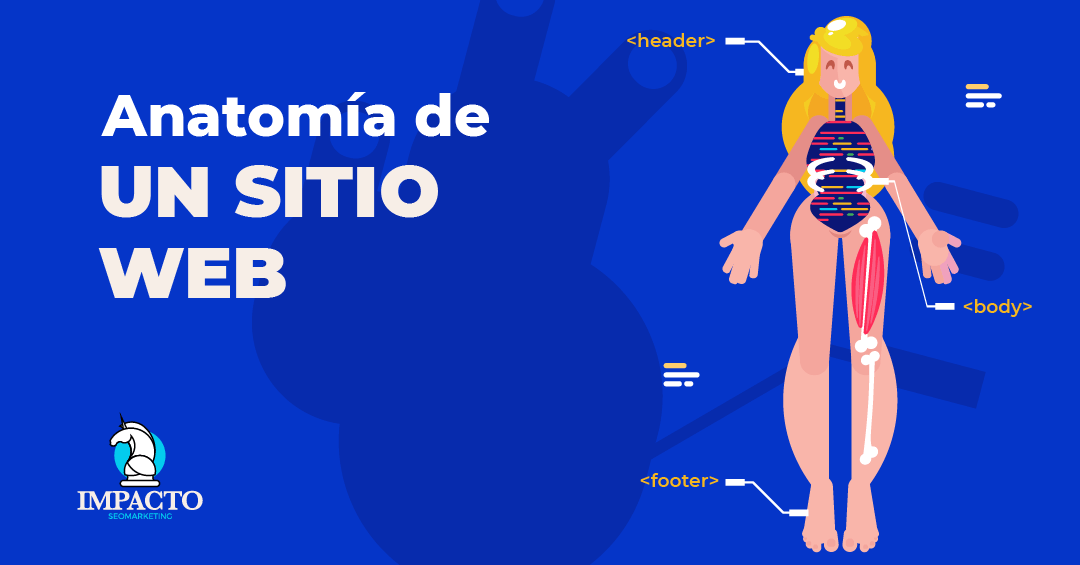

El archivo robots.txt es un archivo de texto simple que se coloca en la raíz de un sitio web. Este archivo es una de las primeras cosas que los robots de los motores de búsqueda buscan cuando llegan a un sitio. A través de unas pocas líneas de código, puedes dictar cómo los motores de búsqueda rastrean y indexan las secciones de tu sitio web.

El archivo robots.txt utiliza «User-agent» para especificar a qué bots de búsqueda se aplica una determinada regla y «Disallow» para indicar las páginas o carpetas que no deben ser rastreadas. También puedes usar «Allow» para especificar las páginas que sí deben ser rastreadas, incluso dentro de una sección previamente deshabilitada.

Es importante tener en cuenta que los robots.txt son públicos, por lo que no se deben usar para ocultar información confidencial. Además, no todos los bots respetan las reglas establecidas en el archivo robots.txt. Los bots legítimos de los motores de búsqueda como Google sí lo hacen, pero los bots maliciosos a menudo ignoran este archivo.

Funciones y utilidad del archivo robots.txt

El archivo robots.txt desempeña un papel fundamental en la optimización de motores de búsqueda (SEO) porque ayuda a los robots de los motores de búsqueda a entender qué partes de tu sitio web deben rastrear e indexar y cuáles no.

El archivo robots.txt es especialmente útil para:

- Gestionar los recursos del rastreador: Los robots de los motores de búsqueda tienen un presupuesto de rastreo limitado para cada sitio, lo que significa que sólo pasarán cierto tiempo en tu sitio. Al bloquear el acceso a las páginas que no son importantes o necesarias para la búsqueda (como páginas duplicadas, páginas de prueba, scripts o estilos), puedes asegurarte de que los motores de búsqueda utilicen su tiempo de manera más eficiente rastreando e indexando el contenido relevante.

- Prevenir la indexación de páginas no deseadas: A veces, puede que no quieras que ciertas páginas de tu sitio aparezcan en los resultados de búsqueda. Por ejemplo, puede que tengas una página de «gracias» después de que un usuario se suscriba a tu newsletter o complete una compra. Como esta página no tiene valor para los usuarios que llegan desde un motor de búsqueda, puedes usar robots.txt para evitar que los motores de búsqueda la indexen.

- Evitar problemas de contenido duplicado: Los motores de búsqueda penalizan a los sitios que tienen contenido duplicado. Si tienes varias versiones de la misma página (por ejemplo, una versión de impresión y una versión online), puedes usar robots.txt para indicar a los motores de búsqueda qué versión deben indexar.

Aunque robots.txt es una herramienta útil, hay que tener cuidado al usarla, ya que un uso incorrecto puede hacer que los motores de búsqueda ignoren por completo tu sitio. Es importante recordar que el archivo robots.txt no debe ser utilizado para controlar la indexación de páginas importantes que contribuyen a tu SEO.

¿Qué es Disallow en robots.txt?

La directiva «Disallow» es una de las más utilizadas dentro del archivo robots.txt. Su función principal es indicar a los robots de los motores de búsqueda qué partes de tu sitio no deben rastrear. De esta manera, puedes tener un mayor control sobre lo que se indexa y se muestra en los resultados de búsqueda.

Cuando editas tu archivo robots.txt para colocar la directiva Disallow en tu archivo, estás pidiendo a los robots de los motores de búsqueda que omitan ciertas partes de tu sitio. Puedes deshabilitar todo el sitio, directorios específicos o páginas específicas.

Por ejemplo:

- Para deshabilitar todo el sitio:

User-agent: *

Disallow: /

- Para deshabilitar un directorio específico (como tu carpeta de imágenes):

User–agent: *

Disallow: /images/

- Para deshabilitar una página específica (como una página de «gracias»):

User-agent: *

Disallow: /thank-you.html

En estos ejemplos, «*» es un comodín que representa a todos los robots de búsqueda. Si solo quieres deshabilitar el acceso a ciertos robots, puedes reemplazar «*» por el nombre del robot. Por ejemplo, si solo quieres deshabilitar el acceso para el robot de Google, usarías «Googlebot» en lugar de «*».

Es importante recordar que la directiva Disallow es una «solicitud» a los robots de los motores de búsqueda y no todos los robots la respetarán. Los bots legítimos como Googlebot seguirán las directivas Disallow, pero los bots maliciosos pueden ignorarlas.

Además, la directiva Disallow no elimina las páginas existentes de los resultados de búsqueda. Si una página ya ha sido indexada y luego agregas una directiva Disallow, la página puede seguir apareciendo en los resultados de búsqueda, aunque Google y otros motores de búsqueda eventualmente dejarán de rastrearla.

Cuándo y por qué usar Disallow

Usar la directiva Disallow en tu archivo robots.txt puede ser útil en una serie de escenarios:

1. Tienes contenido que no deseas que se indexe: Esto podría incluir páginas sensibles como las páginas de administración o de usuario, páginas de agradecimiento o cualquier página que no tenga relevancia para los resultados de búsqueda.

2. Quieres evitar la indexación de contenido duplicado: Si tienes varias versiones de la misma página (como versiones para móvil y para escritorio), puedes utilizar Disallow para evitar la indexación de las versiones duplicadas y prevenir así posibles sanciones de los motores de búsqueda.

3. Deseas conservar tu presupuesto de rastreo: Los motores de búsqueda solo dedicarán cierto tiempo a rastrear tu sitio. Si tienes una gran cantidad de páginas, especialmente si muchas de ellas son de baja calidad o irrelevantes, usar Disallow te permitirá dirigir a los motores de búsqueda a las páginas que realmente importan.

4. Tienes páginas en desarrollo: Si estás trabajando en una nueva sección de tu sitio web que aún no está lista para ser vista por el público, puedes usar Disallow para evitar que los motores de búsqueda la indexen hasta que esté completa.

Cómo realizar un Disallow en robots.txt

Realizar una directiva Disallow en tu archivo robots.txt es un proceso relativamente sencillo. Aquí te presento los pasos para hacerlo:

- Encuentra tu archivo robots.txt: Este archivo se ubica normalmente en la raíz de tu sitio web. Es decir, si tu sitio web es www.misitio.com, el archivo robots.txt se encontrará en www.misitio.com/robots.txt.

- Abre tu archivo robots.txt: Puedes abrir tu archivo robots.txt con cualquier editor de texto. Si aún no tienes un archivo robots.txt, tendrás que crear uno.

- Escribe la directiva Disallow: Comienza con «User-agent:», seguido del bot al que te diriges, y luego escribe «Disallow:» seguido de la ruta que quieres bloquear. Por ejemplo, para bloquear toda tu página a todos los bots, tu archivo robots.txt debería lucir así:User-agent: *

Disallow: /Esto le dice a todos los bots (representados por el «*») que no deben rastrear ninguna parte de tu sitio (representado por «/»).Si, por otro lado, sólo quisieras bloquear una carpeta específica a todos los bots, tu archivo robots.txt debería verse así:User–agent: *

Disallow: /mi-carpeta/Esto le dice a todos los bots que no deben rastrear el directorio «mi-carpeta».Si quisieras bloquear una página específica a un bot específico, tu archivo robots.txt debería estar así:User-agent: Googlebot

Disallow: /mi-pagina.html - Guarda y sube tu archivo robots.txt: Una vez que hayas hecho los cambios, guarda tu archivo robots.txt y súbelo de nuevo a la raíz de tu sitio web. Asegúrate de que el archivo está en la ubicación correcta y que puede ser accesible.

- Verifica tus cambios: Puedes verificar si tus cambios han surtido efecto utilizando la herramienta de prueba de robots.txt de Google, disponible en Google Search Console. Esta herramienta te dirá si tu archivo robots.txt está formateado correctamente y si los cambios que has hecho bloquearán a los bots de la manera que deseas.

Errores comunes y cómo evitarlos

Manejar la directiva Disallow en tu archivo robots.txt puede ser una tarea sencilla, pero también es fácil cometer errores si no se tiene cuidado. Aquí están algunos de los errores más comunes al usar Disallow y cómo puedes evitarlos:

1. Bloquear todo el sitio por error: Es común que los propietarios de sitios web bloqueen accidentalmente todo su sitio a todos los robots. Esto usualmente sucede al colocar ‘Disallow: /’ debajo de ‘User-agent: *’ sin la intención de hacerlo. Para evitar este error, asegúrate de revisar y verificar tu archivo robots.txt después de cualquier cambio.

2. Uso incorrecto de las rutas de Disallow: Las rutas en Disallow son relativas al origen y deben comenzar con «/». Si tu Disallow no comienza con «/», los robots no podrán interpretarlo correctamente. Asegúrate de siempre comenzar tus rutas con «/» para evitar este problema.

3. Olvidar que los robots pueden ignorar el archivo robots.txt: Si bien los robots legítimos respetarán tu archivo robots.txt, los robots maliciosos pueden elegir ignorarlo. No dependas del archivo robots.txt para ocultar información sensible de tu sitio web.

4. Olvidar que Disallow no elimina las páginas de los resultados de búsqueda: Si una página ya ha sido indexada y luego agregas una directiva Disallow, la página puede seguir apareciendo en los resultados de búsqueda. Si necesitas eliminar contenido de los resultados de búsqueda de Google, considera usar la herramienta de eliminación de URLs de Google.

5. No probar tu archivo robots.txt después de realizar cambios: Es fácil cometer errores al modificar tu archivo robots.txt. Siempre asegúrate de probar tu archivo con la herramienta de prueba de robots.txt de Google después de hacer cualquier cambio.

El archivo robots.txt y la directiva Disallow son herramientas poderosas cuando se usan correctamente. Pero ¡cuidado! Que la puedes liar mucho.

Herramientas para verificar y probar tu archivo robots.txt

Para asegurarte de que tu archivo robots.txt funciona como se esperaba y no está bloqueando contenido que debería ser rastreado, puedes usar varias herramientas para verificar y probar tu archivo. Algunas de las más populares:

1. Google Search Console: Herramienta de prueba de robots.txt

Google ofrece una herramienta de prueba de robots.txt gratuita en su Google Search Console. Esta herramienta te permite probar una URL para ver si está bloqueada para Googlebot y también te permite probar cambios en tu archivo robots.txt antes de implementarlos.

Para usar esta herramienta:

- Ve a Google Search Console.

- Haz clic en ‘Antiguo Search Console’ en el menú de la izquierda.

- Haz clic en ‘robots.txt Tester’ bajo ‘Rastreo’.

- Introduce la URL que deseas probar o pega tu archivo robots.txt modificado.

- Haz clic en ‘Test’.

La herramienta de prueba de robots.txt te dirá si tu URL está bloqueada para Googlebot y si hay algún error en tu archivo robots.txt.

2. Herramienta de prueba de robots.txt de Yandex

Yandex, un popular motor de búsqueda en Rusia, también ofrece una herramienta de prueba de robots.txt. Esta herramienta funciona de manera similar a la herramienta de Google y te permite comprobar si tu archivo robots.txt está bloqueando cualquier contenido que debería ser rastreado.

3. Herramientas de análisis de robots.txt de sitios de terceros

Existen varias herramientas de análisis de robots.txt disponibles de proveedores de terceros. Algunas de las más populares incluyen las de SEO Book, Ryte, y Merkle. Estas herramientas te permiten pegar tu archivo robots.txt para comprobar errores, advertencias, y el contenido bloqueado.

4. Validadores de sintaxis de robots.txt

Un validador de sintaxis de robots.txt comprueba si tu archivo robots.txt está formateado correctamente. Uno de los validadores más utilizados es el que ofrece el Robot Exclusion Standard. Este validador te permitirá ver cualquier error de sintaxis que pueda hacer que los motores de búsqueda interpreten incorrectamente tu archivo robots.txt.

Esperamos que esta información te sea de gran utilidad para optimizar el uso de la directiva Disallow en tu archivo robots.txt y para mejorar la visibilidad de tu sitio en los motores de búsqueda. Recuerda que el uso adecuado del archivo robots.txt es esencial para una estrategia de SEO efectiva.

¡Hasta la próxima!