Bienvenidos a este post en el que hablaremos sobre la importancia de editar robots.txt en un sitio web. Este archivo juega un papel crítico en la gestión de los motores de búsqueda y en la forma en que los robots rastrean y acceden a las páginas de un sitio. Es esencial que los dueños de sitios web comprendan el propósito y el uso de este archivo para asegurarse de que su sitio sea indexado y rastreado de la manera correcta. En este post, exploraremos detalladamente qué es el archivo «robots.txt», cómo funciona y cómo editar robots de manera efectiva para garantizar una buena experiencia de búsqueda para los usuarios y un mejor rendimiento para el sitio. ¡Vamos a comenzar!

¿Qué es el archivo robots txt?

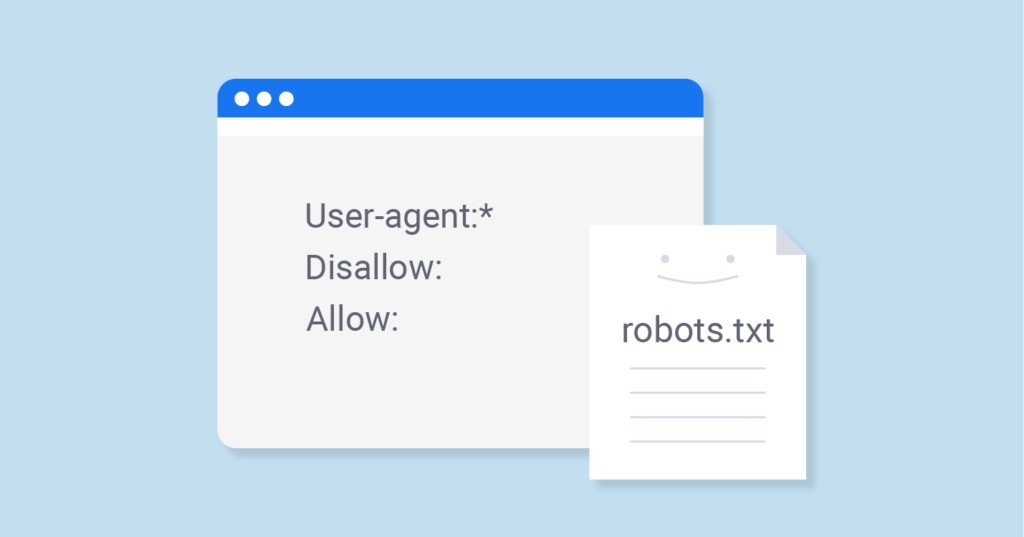

El archivo «robots.txt» es un archivo que se encuentra en la raíz de un sitio web y se utiliza para controlar cómo los motores de búsqueda y los robots rastrean y acceden a las páginas de un sitio. Este archivo es una forma sencilla y efectiva de decirle a los motores de búsqueda qué páginas pueden o no rastrear e indexar.

El archivo «robots.txt» es un archivo de texto simple que incluye líneas de comandos que se utilizan para especificar qué páginas deben rastrear y cuáles no. Por ejemplo, si un sitio tiene una página que contiene información confidencial y no desea que sea rastreada por los motores de búsqueda, puede editar «robots.txt» incluyendo una línea para impedir que esa página sea rastreada.

Es importante tener en cuenta que el archivo «robots.txt» es una «solicitud» y no una «orden». Los motores de búsqueda y los robots no están obligados a cumplir con las solicitudes especificadas en el archivo «robots.txt». Sin embargo, la mayoría de los motores de búsqueda y los robots respetan estas solicitudes y evitan el acceso a las páginas especificadas.

Cómo funciona el archivo robots.txt

El funcionamiento del archivo «robots.txt» es bastante simple. Cuando un motor de búsqueda o un robot encuentra un sitio web, primero verifica si existe un archivo «robots.txt» en la raíz del sitio. Si existe, el motor de búsqueda o el robot accederá a ese archivo para ver las directivas especificadas sobre qué páginas pueden o no ser rastreadas.

Al editar «robots.txt» puedes incluir líneas de comandos que permiten o restringen el acceso a las páginas de un sitio. Por ejemplo, si un sitio incluye una línea de comando que dice «Disallow: /página-confidencial/», significa que el motor de búsqueda o el robot no debería acceder a la página «página-confidencial».

Es importante tener en cuenta que el archivo «robots.txt» no es una garantía de que una página no será rastreada o indexada. Hay algunos motores de búsqueda y robots que pueden ignorar las directivas especificadas en el archivo «robots.txt», por lo que es importante utilizar otros métodos, como la etiqueta «noindex» en el encabezado de la página, para garantizar que la información confidencial no sea rastreada.

En resumen, el archivo «robots.txt» es una forma efectiva de controlar cómo los motores de búsqueda y los robots rastrean y acceden a las páginas de un sitio. Al incluir líneas de comandos que permiten o restringen el acceso a las páginas, los dueños de sitios web pueden garantizar que su sitio sea indexado y rastreado de la manera correcta.

Por qué es importante editar robots.txt

Es importante tener un archivo «robots.txt» correctamente configurado para garantizar que los motores de búsqueda y los robots accedan de manera adecuada a su sitio web. Algunos de los beneficios más importantes que se deben tener en cuenta son:

-

-

Evite restringir el acceso a las páginas importantes: Es importante evitar restringir el acceso a las páginas importantes de su sitio, como la página de inicio y las páginas de productos o servicios, ya que esto puede afectar negativamente su posicionamiento en los resultados de búsqueda.

-

No restrinja accidentalmente el acceso: Es importante asegurarse de que el archivo «robots.txt» no restrinja accidentalmente el acceso a las páginas importantes. Por ejemplo, evite editar robots restringiendo el acceso a las páginas con errores de escritura o a las páginas que ya no están en uso.

-

No use «robots.txt» para proteger información confidencial: El archivo «robots.txt» no es una forma segura de proteger la información confidencial. Si desea proteger información confidencial, debe utilizar otros métodos, como la autenticación de usuario o la cifrado de datos.

-

Verifique que su archivo «robots.txt» esté funcionando correctamente: Es importante verificar regularmente que su archivo «robots.txt» esté funcionando correctamente y que no esté restringiendo accidentalmente el acceso a las páginas importantes.

-

Cómo editar robots.txt

Cómo editar robots.txt de manera efectiva, incluyendo ejemplos de códigos comunes y la forma en que deben utilizarse:

-

Acceda a su sitio web: Para editar «robots.txt», primero debe acceder a su sitio web. Puede hacerlo a través de un cliente FTP o a través de la sección de archivos de su panel de control de hosting.

-

Cree un nuevo archivo «robots.txt»: Si aún no tiene un archivo «robots.txt» en su sitio, puede crear uno nuevo. Simplemente cree un nuevo archivo de texto y guarde como «robots.txt».

-

Añada instrucciones de robots: Una vez que haya creado el archivo «robots.txt», puede comenzar a añadir instrucciones para los robots. Los siguientes son algunos ejemplos de códigos comunes que puede incluir:

-

- User-agent: *: Este código indica a los robots que deben seguir todas las instrucciones que se encuentran en el archivo «robots.txt».

- Disallow: /directorio/: Al editar robots con este código indicas que no deben acceder a un directorio específico en su sitio.

- Allow: /directorio/página.html: Este código le indica a los robots que deben acceder a una página específica dentro de un directorio restringido.

-

Guarde sus cambios: Una vez que haya agregado sus instrucciones de robots, asegúrese de guardar sus cambios antes de cerrar el archivo.

-

Verifique su archivo «robots.txt»: Por último, es importante verificar que su archivo «robots.txt» está funcionando correctamente. Puede hacerlo ingresando a «https://www.example.com/robots.txt» en su navegador, reemplazando «www.example.com» con el nombre de dominio de su sitio web.

Configuración del archivo robots.txt

En primer lugar, tenemos el plugin Yoast SEO, el plugin SEO más popular de todo WordPress con muchísima diferencia. Además de permitirte ordenar las páginas y de añadir metaetiquetas, te facilita la incorporación del archivo robots.txt desde la sección Herramientas. En segundo lugar, a través de otros plugins parecidos a Yoast SEO como All in One SEO Pack. En tercer lugar, a través de la creación del propio robots.txt a través del FTP. Ahora ya sabes cómo crear un archivo robots.txt y añadirlo a tu sitio web WordPress.

¿Dónde encontrar el archivo robots txt?

Poder comprobar las instrucciones actuales que nuestro archivo robots.txt aportan a los rastreadores de los buscadores es muy importante. Por esto es importante conocer cómo ver el robot.txt de una página. Y esto pasa por escribir en el navegador la URL de tu sitio web seguida de «/robots.txt». Así, y en el caso de nuestro sitio web, titulado impactoseo.com, la ruta para encontrar el archivo robot sería impactoseo.com/robots.txt. Eso puede servirte también para inspeccionar los archivos robots de tus competidores.